浅谈Service Mesh体系中的Envoy

- 将统计数据放入共享记忆中。

- 对于Unix Domain Socket 通信,新旧程序都采用标准RPC协议。

- 在新程序启动并完成所有启动程序后,已要求提供前一个程序的窃听器副本。

- 旧程序被告知在新程序接管后关闭软件包。

- 告诉旧程序,它即将结束。

- 在数据小组中增加 " 侧面车 " 将延长业务请求链的长度,并肯定会造成业绩损失,因此,扩大对预先执行请求的了解将是每部侧面车最终成功的重要因素之一。

- 控制面板由中央地点管理。使所要求的有效性核查、流动控制和遥测数据的收集和分析同步进行,因此Sidecar必须把所有请求都转交我们得跟控制板谈谈例如,在伊斯蒂奥的结构中,Meixer 组件处理这项工作的这一方面。因此,你可以预期,这将是业绩瓶颈之一。问题是,Istio的行政当局已经设计出一种纠正这种情况的办法。几天前政府宣布, 它能将Mixer的大部分工作 转移到Sidecar。列入一个混音器来处理验证、流动管理、数据收集和统计等要求,相当于特使。MixerFilter必须经常与Istio联系,以便装载数据和获取最新的配置数据。这是利用莫坦、梅舍尔、伊斯蒂奥前和OSP完成的。

- 拦截业务透明度要求。

- 根据一套规则对拦截请求进行审查、核证、统计、交通管制、路由器等依据。

- 将请求转发出去,侧面车负责ServiceMesh的所有交通因此,Sidecar负责所有互联网通信。因此很明显,当请求发出后,Sidecar将是下一个收到请求的人。Sidecar之间通信安排的效力也将对ServiceMesh的总体成功产生重大影响。

- 由于其自身顺序的特点,当规则更严密地配置时,性能就会急剧受损。

- 每个request的处理都要经过内核态--->用户态--->内核态的过程,因此,数据将从内核状态转移到用户状态。我们无法完成这个任务, 但我们能够完成这个任务。一项请求表明,其使用量确实很少。然而,作为一个交通守门员 进出交通,每秒要求的数量一定相当高。使用总量肯定相当高。政府几天前宣布,由于互联网上有大量的成套数据,政府无法这样做。这将造成经常的硬件中断、环境变化和其他类型的冲突。数据包甚至可用于不同CPU之间的交换处理。这些变数加在一起可能导致重大性能损失。

- 世界上最受欢迎的核集团,Linux核共同体,最近出版了《过滤器》。以Linux BPF为基础的高性能网络过滤内核模块。该项目的目标是将Netfilter替换为iptable 内核。正在进行心脏改变手术,以便将Linux用户迁移到BPF。

- 特使正在推动对其结构进行正式的重新设计。目标是为自定义的网络套接字提供支持。当然,最终目标是纳入VPP(Vectictor Packet processing)和扩展支持。包件既可以用纯用户处理,也可以用内核状态处理,这取决于是使用VPP还是使用。为了避免记忆的回转, 切换上下文 。这不是Linux的唯一出路,但它是Linux的唯一出路。为了提高信息传递的效率,因此,目标是提高拦截请求的效率。

- 访问设备的内存。 UIO 核心完成 mmap, 包括物理内存、 逻辑内存和虚拟内存。 UIO 的动机是不需要解决这些不方便的问题。

- 由于对设备中断的反应必须发生在内核空间, UIO只储存了内核的一小部分代码逻辑,剩下的逻辑留给用户空间过程。

- XDP不支持缓存队列(qdisc),如果TX设备太慢,无法在比TX更快的RX设备上使用XDP,则直接拒绝TX设备。

- XDP软件专门用于网络协议储存,没有广泛应用。

- Golang实现。

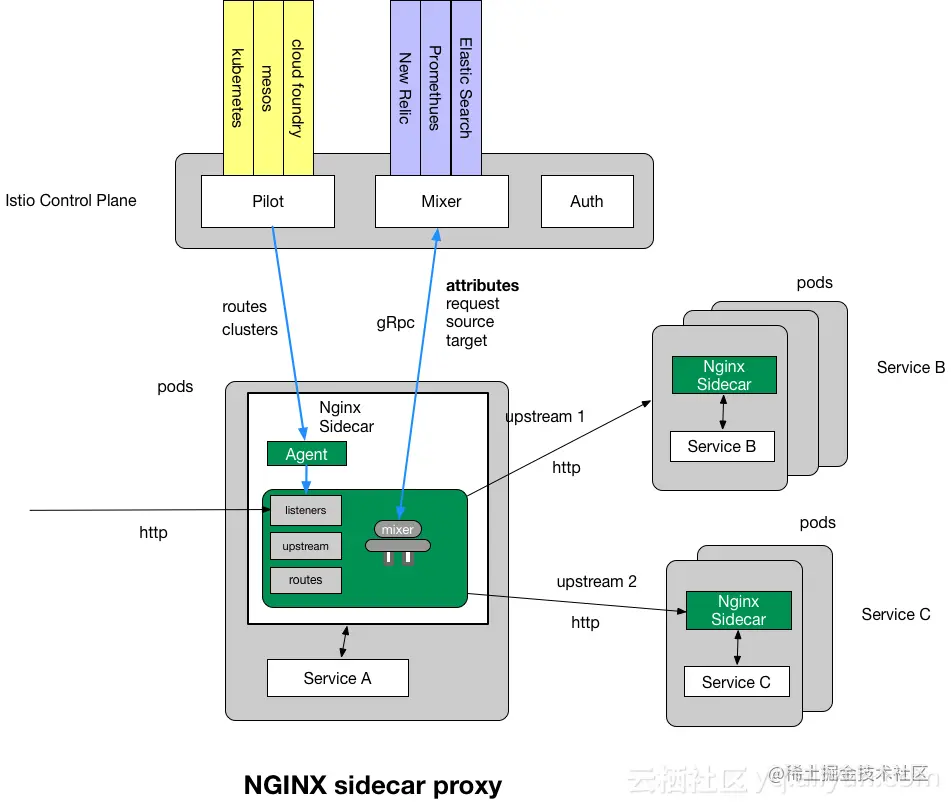

- 侧面car 实现模式: 代理 + nginx, 代理负责监测 Istio 配置的变化( 如路线规则、 集集数据、 服务发现等 ) 。 然后将其修改为 gnx 配置, 然后重新开始应用 nginx 配置

- 与icio, k8s, k8s 和 k8s 的“ 启动器” 系统隔绝, 以创建自动的侧车充气。

- 生产环境还没有被验证

- 虽然 nginx 可以用 ngixscript/lua 扩展, 但主要局限于 http 进程, L3L4 过滤器无效 。

- 部署图如下:

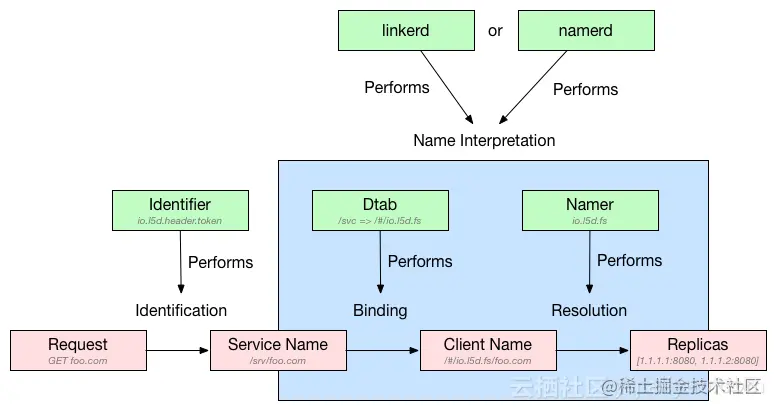

- 在爪哇虚拟机器上运行的Scala语言发展,是“服务网”概念的发明者,已证明生产稳定。

- 该结构建在Netty和Finagle上,在RPC楼层运作。

- 基于文件的、 Zookeper 和 k8 是插入服务的例子 。

- 由于RPC楼层的工作已经完成,可根据实时看到RPC的延误、处理请求的排队大小选择请求的分布,并且优于典型的启蒙和平衡技术,如LRU、TPC活动请求等。

- 两个分庭(P2C):最后的分庭、最后的分庭、最后的分庭、最后的分庭、最后的分庭、最后的分庭、最后的分庭、最后的分庭、最后的分庭、最后的分庭、最后的分庭、莱斯特·洛伊德分庭和罗德-鲁宾分庭是现有的负载平衡算法。

- 数据流程图如下:

- 他出生在林格尔德城鉴于林克德的部署方法过于复杂,我认为这是一个极好的概念。服务网旨在最快捷、最轻、最容易使用。为了开发数据平面 我们必须利用拉斯特建立控制飞机,使用Go。加上布云特的林格尔德

- Istio是一个控制平面,既包括数据平面,也包括控制平面,用户可通过Conduit CLI和Web UI进入控制平面。

- 只有 K8 可用于运行 。

- 目前,零版已经发布,第三版目前处于早期开发阶段。

- 对于通过管道代理传输的交通,已经制定了一些监测指标。Prometheus是指示格式。该材料被保存在代理监控港口的测量路径下。普罗米修斯可以立即掌握指标的内容。做聚合展示。

- 为确保自身安全,使用鲁斯特固有的语言安全机制。

最后更新:2022-04-02 00:16:14 手机定位技术交流文章

背景

最近,对为工作目的了解到的Service Mesh和特使的内容进行了认真的汇编,并交存了文件,但鉴于资料有限,例如文件的错误描述,希望发出指示。

在讨论特使时,你还必须讨论Service Mesh。在讨论服务网时,讨论微观服务至关重要。因此,让我们放下特使。关于Microsservice、Service Mesh和Service Mesh特使作用的概览。

过去几年中,建筑结构最引人注目的方向是服务部门;因此,微观服务给我们带来了什么好处? 下图描述了建筑结构的进展:

由于公司规模扩大,微观服务的好处是不言自明的。例如,其可缩放性、可持续性、失败和资源分离等固有特性导致产品制造研究与开发效率大幅提高。同时,它以微观服务结构为基础。研究人员和开发商可以创造自然而然的“宽敞友好”系统。它为商品的不断整合和出版提供便利。

然而,没有所谓的银子弹。微观服务的好处并非没有它们的缺点。在云原生模型里,数百项服务可合并为一个应用程序。每项服务都可能有数千例。每个案件的地位都可能在今后发生变化。此时,机构间互动不仅极其复杂,而且极其困难。一切都在运行时完成。在确保端对端业绩和可靠性方面,处理服务间互动无疑是最高优先事项。在众天神到来之前,SDK软件主要用于微观服务框架之间的通信。尽管如此,这显然是一项短期战略。例如,它具有侵扰性,没有办法提升SDK使之隐形。

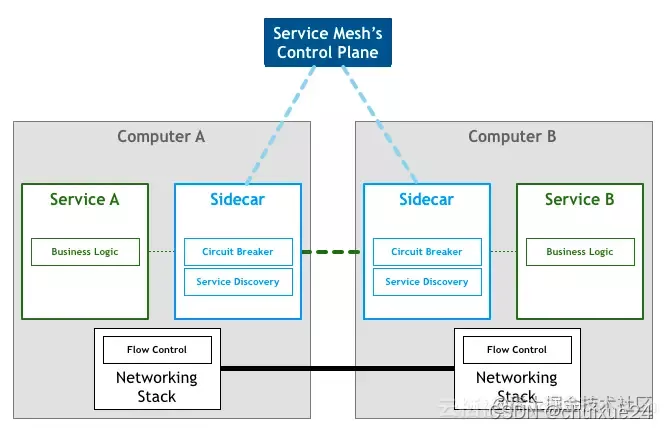

由于所有这些复杂的原因,各处之间缺乏沟通,促使建立了服务间沟通层。这一层不应与申请代码相协调。它还探测海底环境的动态变化,并作出必要的修改。它还使开发商能够集中精力经营自己的企业。云层化引起的许多问题以非侵入方式向开发者公布。

Service Mesh是先前描述的服务间通信程度,通常转化为国内的服务网。它能够进行安全、迅速和可靠的服务间沟通。如果用一个句子来描述什么是服务网格,它类似于微服务中的TCP/IP层。负责服务间通话、流量限制、熔炼和监测等等。

当你读到它时,肯定还存在这样的疑问。这是什么,服务网网?这是全新的东西吗?它的轨迹是什么?

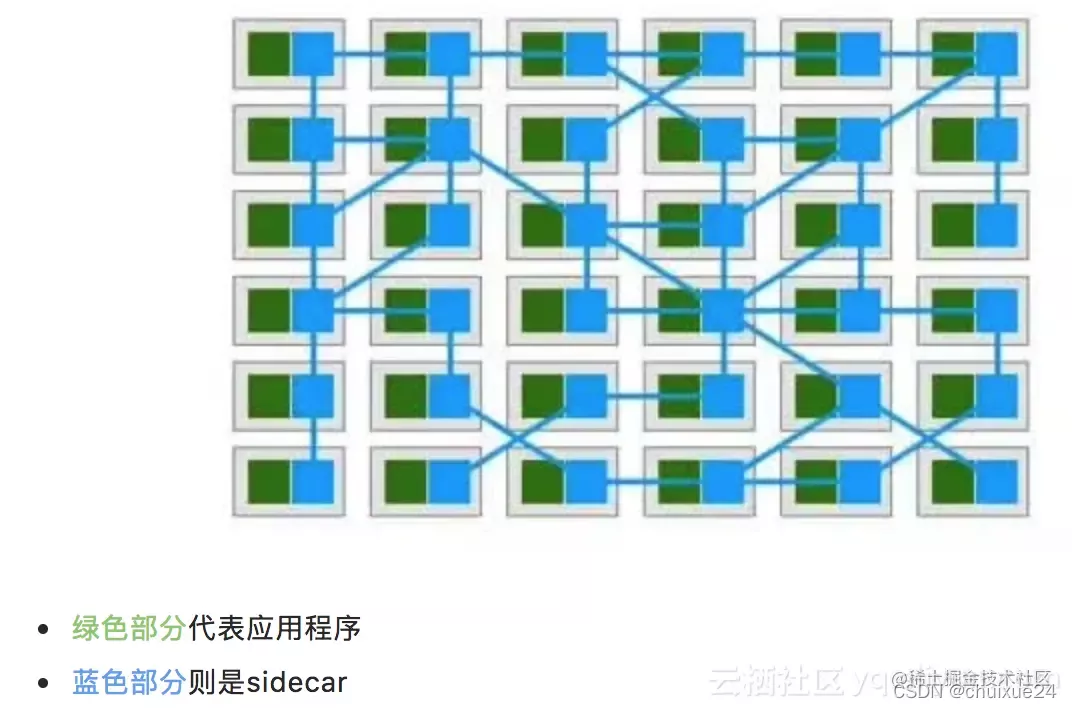

如上图所示,最初的Service Mesh从一个网络代理开始。Linkerd是该行业第一个开放源码倡议,于2016年1月发布。同年9月29日, 在SF微服务会议上,“服务网”一词首次在公共场合使用。此后,特使发表了自己的公开来源版本。但Service Mesh现在比以往更处于侧面车级。侧面车没有明确的管理结构。因此,它是第一代服务网。目前,尽管塞尔维亚Mesh仍然处于萌芽阶段,但无法摆脱困境。另一方面,还形成了一个胚胎间服务通信层。如下图:

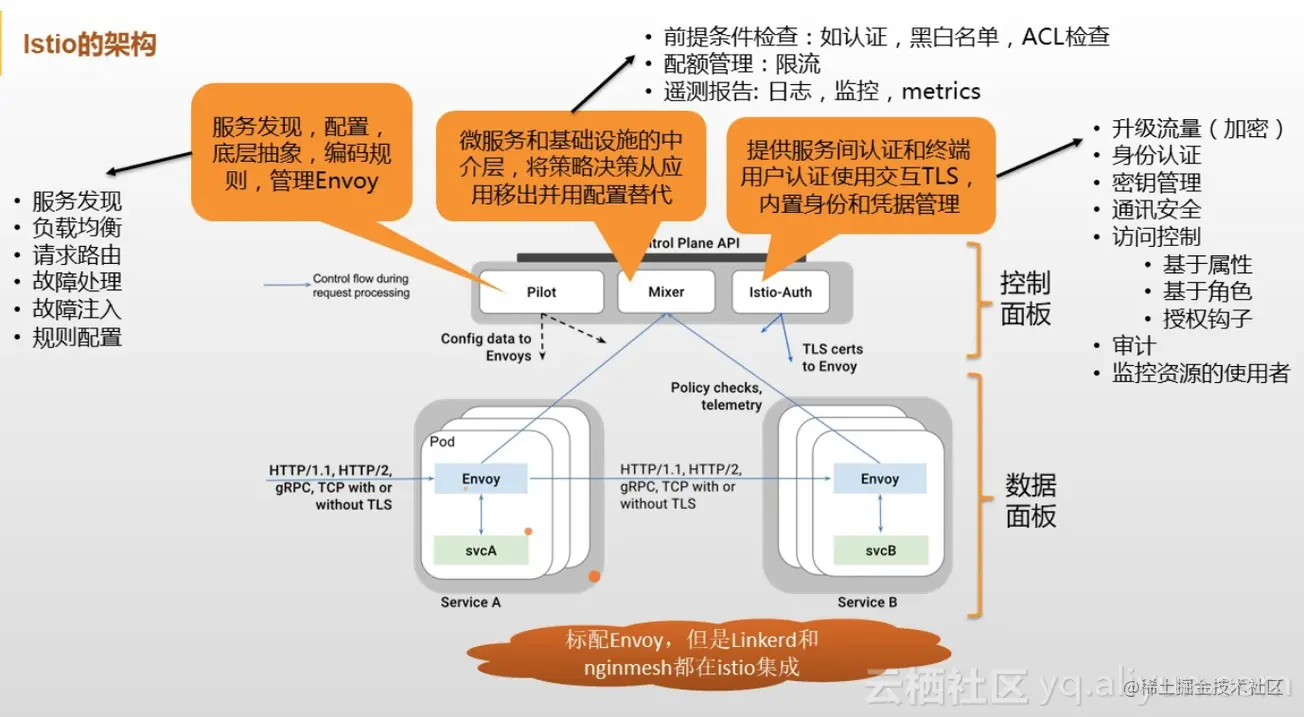

谷歌与IBM和Lyft合作,在结构层面,已明确了数据和控制水平。中央控制飞机的想法也提高了服务网的效用。除了对巨人的支持外, 作者写道:因此,Service Mesh、Istio和Istio的理念立即被点燃。它目前是第二代服务网网,也是世界第二代服务网。飞机控制的概念和目的广为人知。更为关键的是建立一个成熟的SDN服务通信层。目前, " 服务网网 " 结构如下:

然后介绍了服务网的背景材料,我们接着谈到特使具有重大意义的问题。

在伊斯蒂奥,特使是官方的侧车标签。它是一个网络代理商,在服务结构方面表现良好。由C++语言实现,我们有巨大的适应能力。请求发送过程的一半以上可以使用过滤器方法定制。Nginx是业绩方面的业绩参考。也处于主流水平,当然还有很多特性,这里没有序言。

以单一组合为基础的特使总流程

任何软件架构设计,这是所有关于数据, 只有数据。数据结构的基本规格界定了过程的方向。项目其余部分的建造方式使他们有能力这样做。我们不能忽视那些已经改变的部分 和那些没有改变的部分。过程的相同组成部分最终将改变为过程的主流。基本固化,更新的目的是使其尽可能广泛和简单。它最终在初级进程中转变为抽象的进程节点。

特使的情况没有例外。作为网站技术主管其主要作用是完成请求传送。人们希望,在整个传输过程中,可以对它作一些适度的处理。例如,考虑列入头人财产。如果情况并非如此,就不需要代理程序。那么,特使是如何工作的呢?具体说明其数据结构的方式,软件结构 以及围绕数据结构的程序程序成为它的一部分是多么令人费解。保证高扩展性呢?

使用这些问题,假设特使作为一个高度定制的程序,拥有一个总是为提供信息而配置的直言不讳的载体,然后试图从特使的配置中读取其结构和方案业务。

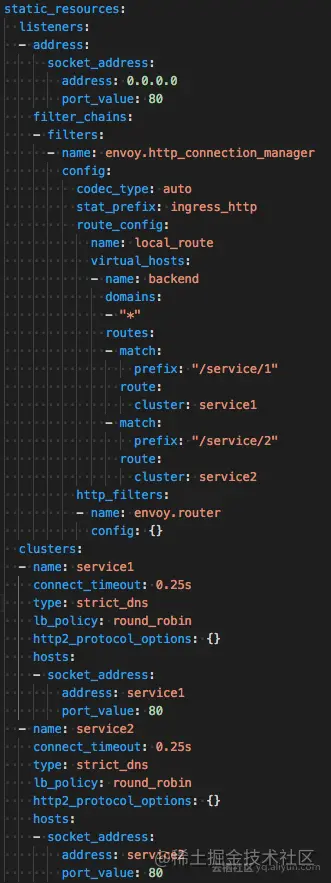

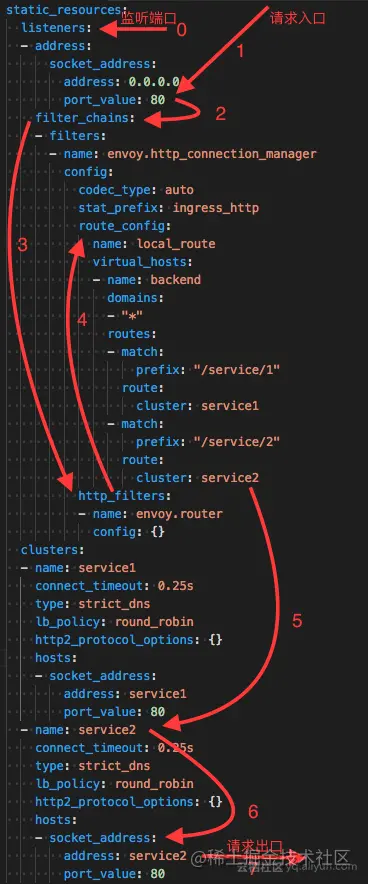

在查看其配置前,我们来计划一下我们接下来要怎么做吧比如作为一个代理,第一步是获取请求流量。这往往是通过听取港口的意见来实现的。其次,在获得所需数据后,你必须对数据进行一些小处理。例如,除其他外,插入页眉头或检查页眉字段的内容。就资料来源而言,有多种层次的数据。我们可以分解成L3L4L7然后,又发出这一请求。如果后端是一个集群,它是一个集群。必须从其中挑选机器。例如,负载平衡在如何选择方面可以发挥作用。应该是这样的 应该是这样的 应该是这样的 应该是这样的 那样的 那样的 那样的 那样的 那样的 那样的 那样的 那样的 那样的 那样的 那样的 那样的让我们看看特使现在是如何安排其配置的。

特使的基本设置信息如下:

关键字段说明:

Lissteiner : 听者服务( 进程) 。 这是真正的工作 。 特使会将一个或一个以上的收听者请求披露到下游监听 。

过滤器:特使核心逻辑处理模块是指各种“可插入”和串通逻辑处理层。

路由_ config: 路线规则配置, 即请求到后端群组( 群组) 的路线 。

特使通过服务找到分组成员并获得服务,以负载平衡方式决定哪个分组成员收到请求,分组成员的服务状况通过健康筛查服务进行评估。

根据上述大脑补丁程序,并结合这一配置,特使的总体方法分析程序如下:

在特使内部,处理请求的过程基本上与传播我们想法的过程相同。换言之,请求处理程序基本相同。而对于变化的部分,这是对所要求的数据的微处理。抽象的一切都是过滤器例如,ReadFilter、WriterFilter和请愿书作者读写请求书。HTTP 请求的数据编码为 StreamEncoderFilter, StreamDecoderFilter 。TcpProxyFilter是TCP治疗。他的祖先是《读物报》HTTP 通过连接管理器处理 。也从ReadFilter和其他人那里传下来。每个过滤器最终将被安排为过滤链。过滤链是在收到请求后第一个离开的。第二条路线连接到指定的组群,并进行负负平衡,以获得目标地址。然后转发出去。

浅谈Envoy架构

在讨论了基本程序之后,这一部分将试图分析其结构设计,以便从中获取一些价值。

在我们开始之前,先考虑一个令人感兴趣的问题:特使是否真的利用C++开发,通常承认C++实施优胜者,然后又假设特使的设计似乎追求高绩效?

在探讨特使结构之前,先考虑特使自己关于设计目标的说明,其设计目标如下:

特使的工作并非非常缓慢(我们花费了大量精力改进重要的渠道)。基于模块化编码,易于测试,而不是性能最优。我们的观点是,以其他语文或以效率低得多的方式运作的系统使用,特使的部署和利用可以提高业务效率。

令人感兴趣的是,特使的结构设计并非旨在实现极端的绩效;这是否会对绩效产生负面影响?

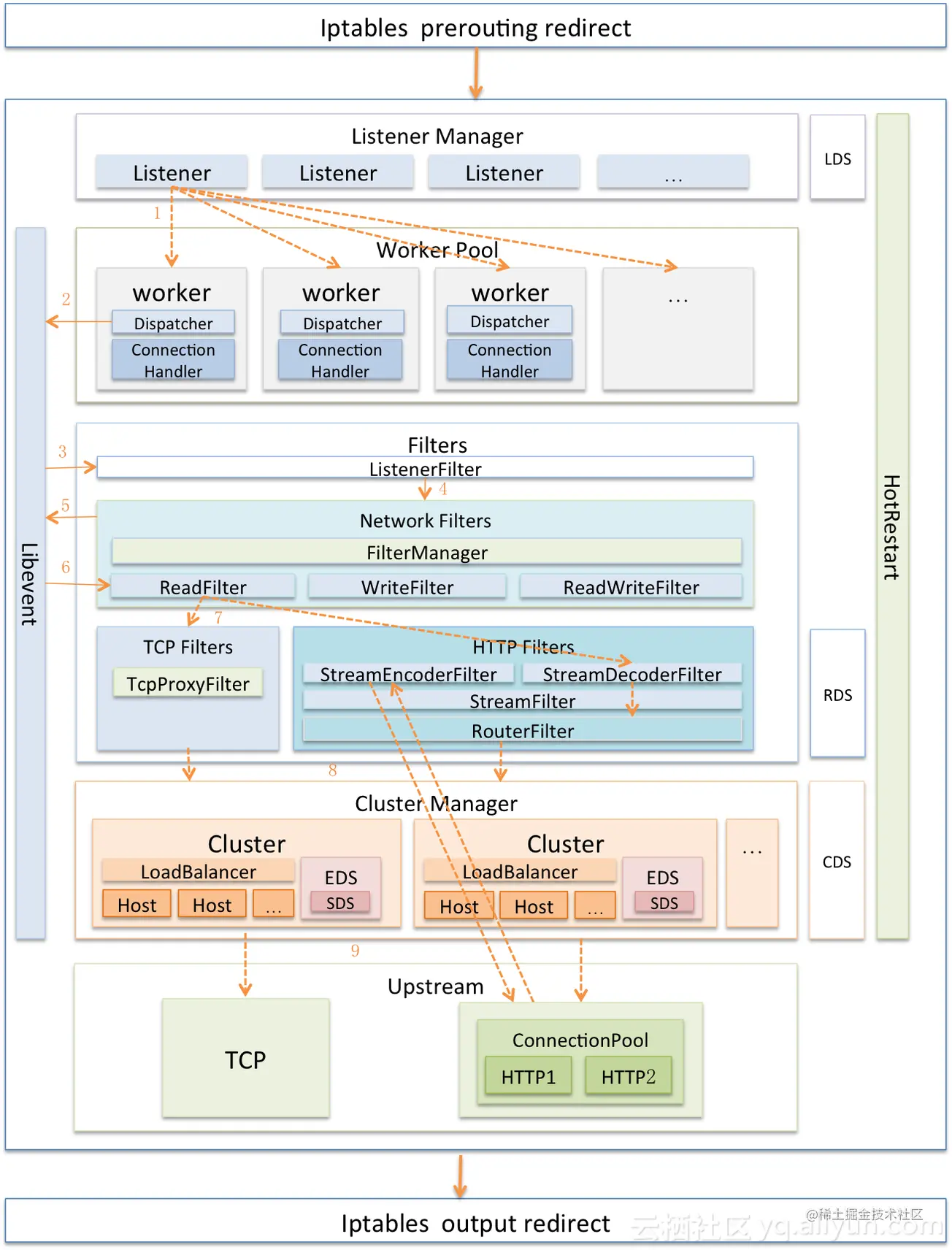

目前,Nginx是这一行业中最著名的代理方法,因为它采用了全线一线一线事件模型,这一结构在行业中得到广泛使用。特使,他呢?让我们看看下图:

看到工人的内部工作方式很奇怪会不会有什么误会?呵呵,没错,特使还使用Nginx式建筑。将多线 + 非阻塞 + 无症状 IMO (利贝特) 合并。尽管特使的目的不是以出色表现为目的,但不可能实现。但不等于没有追求,只是比扩张小一点而已

特使的另一个方面是能够实时更新配置信息。XDS 模块处理该函数。XDS是个统称,ADS(分类发现服务)、SDS(系统)是两个例子。 Service Discovery Service )、EDS( Endpoint Discovery Service )、CDS( Cluster Discovery Service )、RDS( Route Discovery Service )、LDS( Listener Discovery Service )。XDS 模块的功能是从 Istio 的 Pilot 获取动态配置信息 。调用配置的方法分为两个版本:V1和V2。V1采用HTTP,V2采用gRPC。

根据以下概念,特使还促成热重新启动,在重新启动时可以顺利连接:

像恩京克斯一样,特使支持Lua过滤器,但它在HTTP楼层工作,实际实现概念是相同的,没有重复。

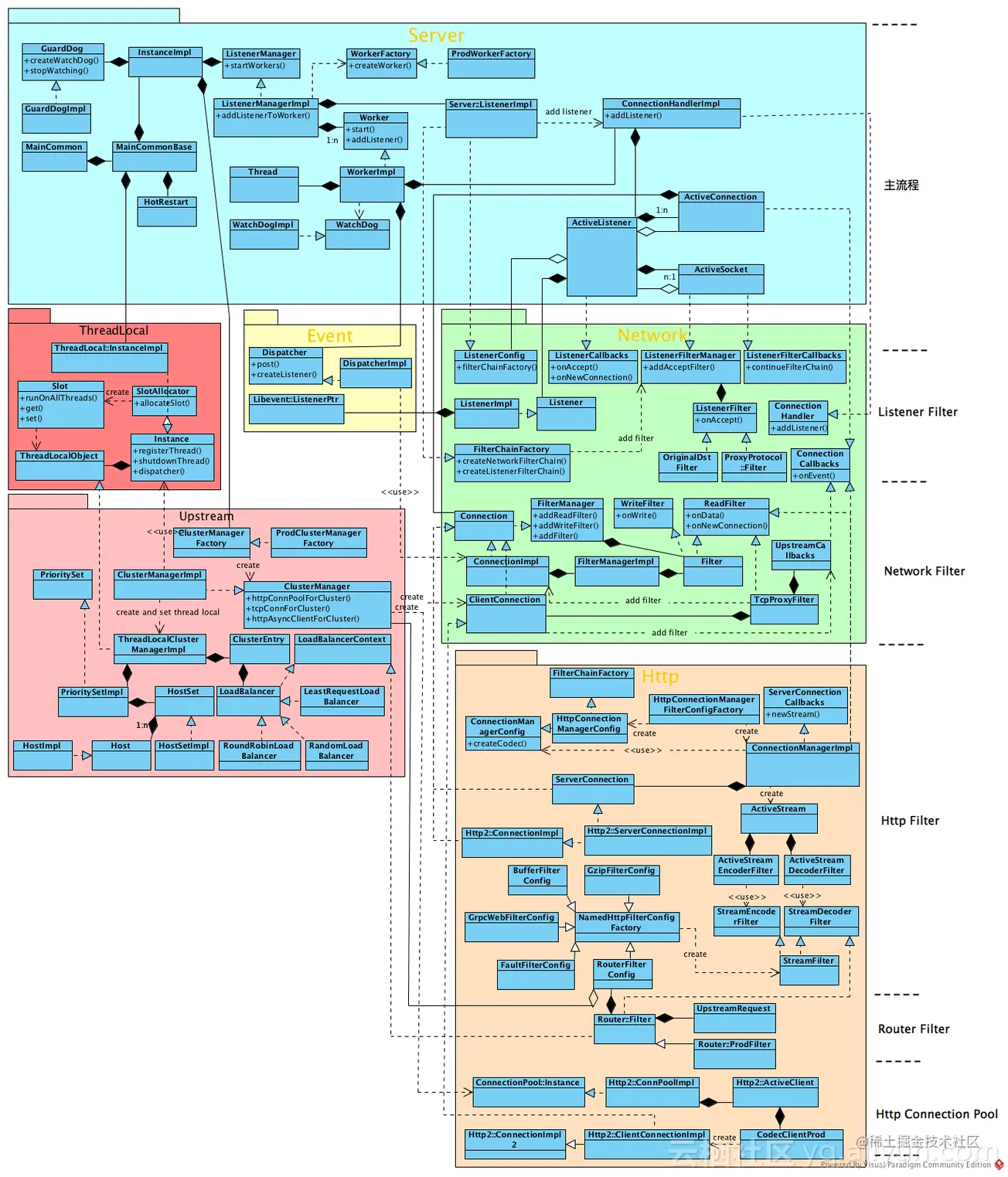

到目前为止,我们已经观察了上面的结构, 如果你对它内部的实现感到好奇, 你可以看到下面的模式:

其内部现实为灵活性带来了一些抽象的信封,尽管如上所述,基本上可以分为许多广泛的功能单元,而无需作出更多解释。

Envoy性能谈

软件行业从未出现过银弹,尽管ServiceMesh的好处是显而易见的,甚至被称为服务间层,但不可否认的是,ServiceMesh的进入造成了应用性能的损失,这可以从两个方面看出:

本节重点介绍特使的业绩举措以及社区高业绩形象的其他方面。

侧面车的基本职能,特使,可以快速地在三点阐述:

我们试图根据上述三点评估业绩改进的主要方面,以便根据上述三点评估业绩改进的主要方面。第一和第三点与商业关系不大。属于通用型功能,第二点的成功 对企业的复杂性很重要例如,核查规则请求的数量和种类、遥测数据收集的准确性、数据统计层面的多样性等等。因此,所请求的拦截与Sidecar之间的通信协议的有效性是增加Sidecar性能的最可能的领域。

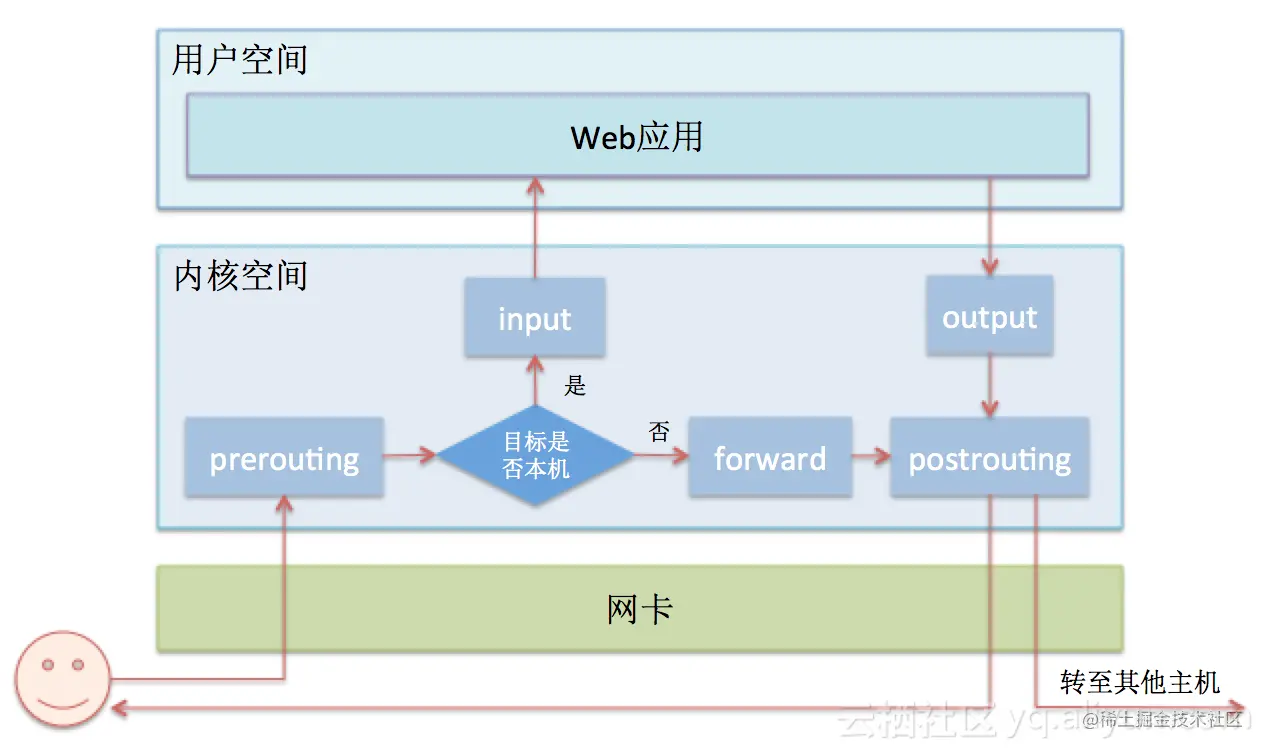

针对请求的拦截,现行程序是利用iptables。就Sidecar公司而言,拦截规则在便表中界定。当请求出现时, ibtable 将寻找匹配规则, 从规则列表的上到下。如果没有符合的规则,它只是退一步, 它只是退一步。如果有符合的规则,为执行和遵守某些规则(接受、拒绝、记录等)而采取的行动。确定执行进程的下一个阶段。为了更直观地展示伊发程序,我们与执行伊发程序有许多关系。请看下图:

在了解基本工作程序之后,不难发现两个主要的业绩瓶颈:

由于人们充分认识到品位不足,优化手段必须同时涉及,林努斯人和特使希望实现以下目标:

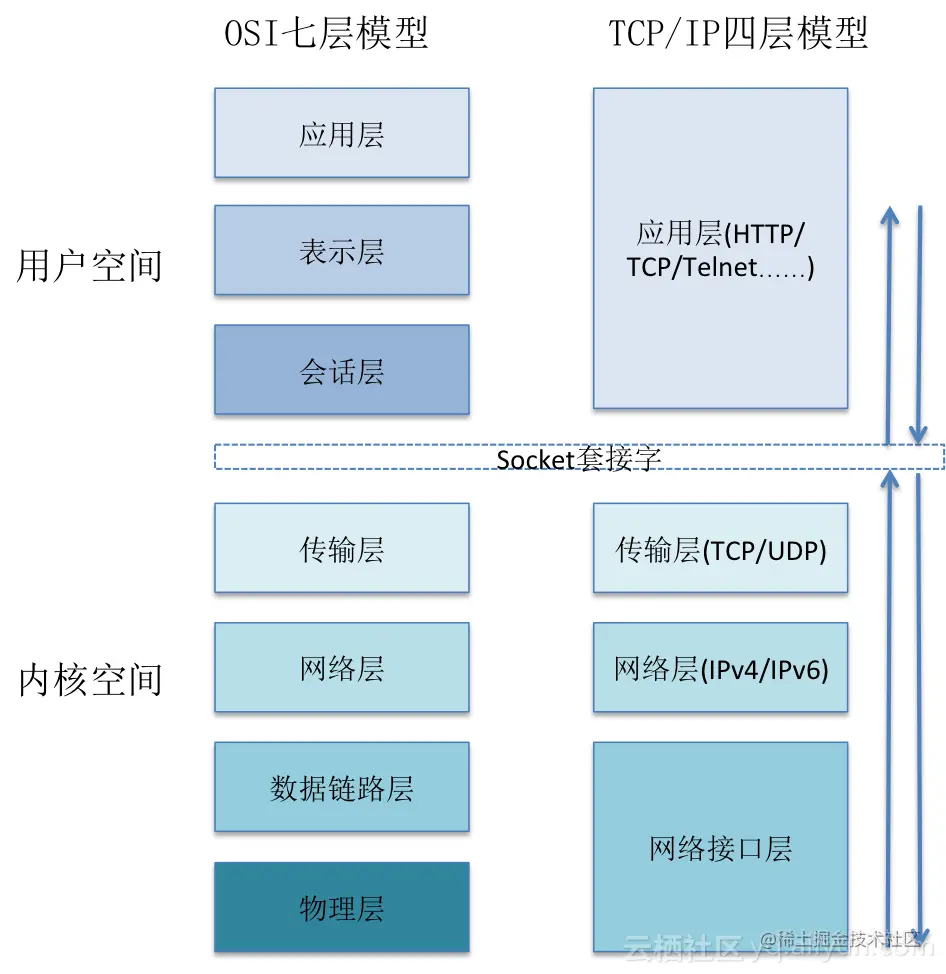

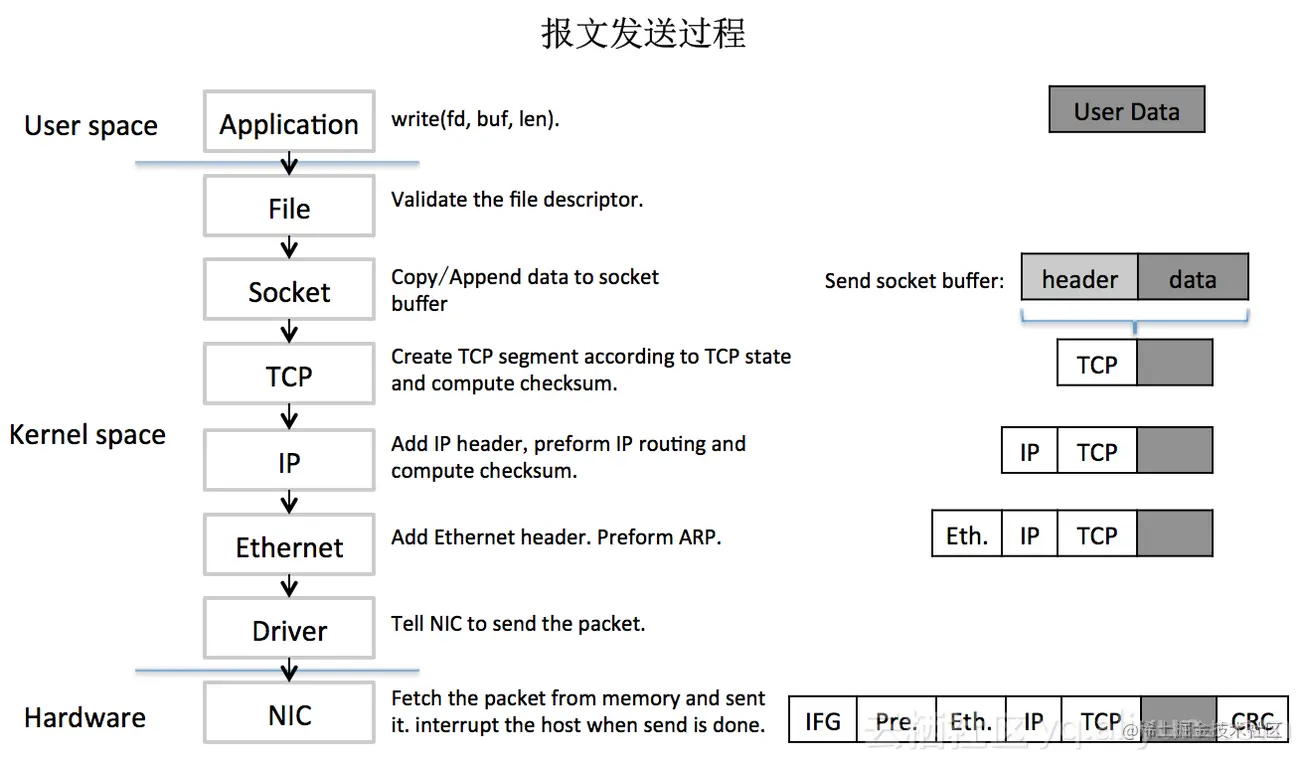

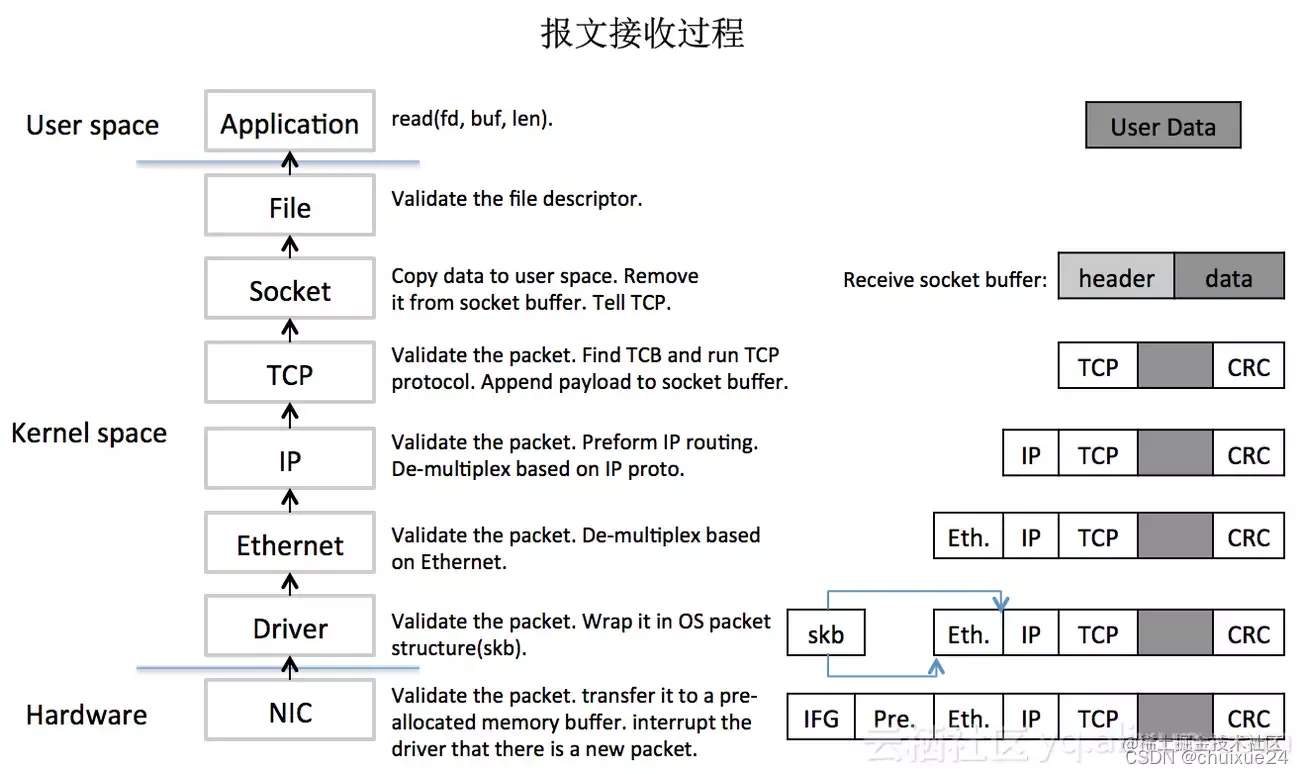

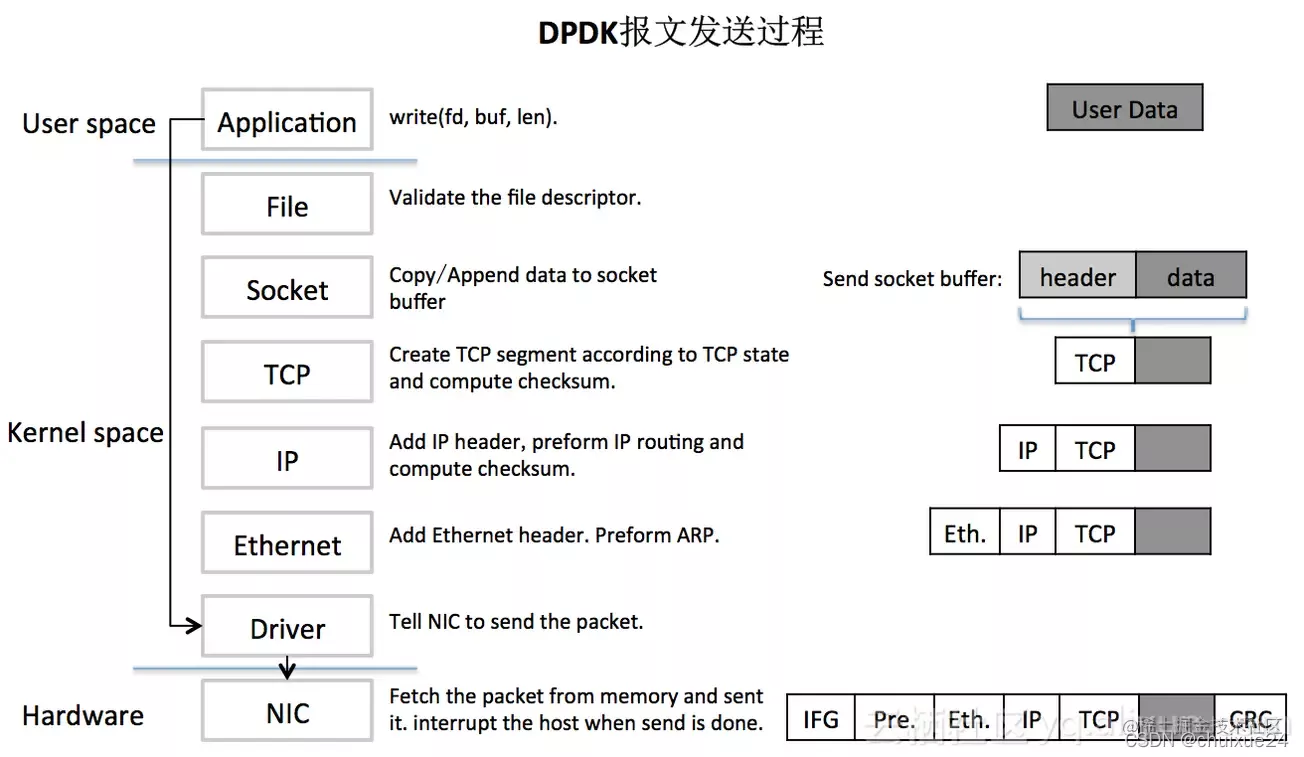

为什么在标准Linux协议处理过程中避免核子状态和用户状态转换至关重要?例如,考虑一下我们最直觉的记忆副本。正常情况下,从网页卡到申请的网络数据包要求采用以下程序:数据通过DMA等内核创建的缓冲区从网络卡中发送。然后从内核空间复制到用户状态空间在Linux内核,这一耗时活动占包件总处理时间的57.1%。很难找到一种摆脱环境的方法 来掌握记忆拷贝 更直觉地消耗。画了一张简图,如下:

简说DPDK

英特尔数据计划开发工具包是英特尔数据计划软件开发工具包。这是英特尔公司提供的一系列数据级发展工具。提供图书馆功能和驱动器支持,以便在英特尔建筑(IA)处理器的用户空间中高效处理数据包,在通用设计方面,它不同于Linux系统。它侧重于在网络应用程序中处理高性能数据包。它将数据处理、记忆管理和CPU排期移到用户空间。与此相反,内核只负责部分控制指示。这解决了处理数据包时系统中断、上下文转换、系统呼叫、系统时间安排等等问题。

矢量包处理器缩写为VPP。这是一种基于DPDK的基于网络的框架处理解决方案。是一个可扩展框架,在个案基础上,为案件开审提供总机/路由功能。国际开发部是Linux基金会的一个开放源码项目,是IO的次级项目。Cisco的开放源码版本。目前是FBI 木卫一的主要项目

虽然整个DPDK仍然相当复杂,但不可能在一、两条中理解,重点不是DPDK,下文简要概述了其逻辑,这使我们基本了解特使采用VPP将大大提高请求处理程序的效率的原因。

为了了解科索沃民主党如何大大改进了一揽子方案的处理性能,考虑在Linux接收和分发标准一揽子方案,具体如下:

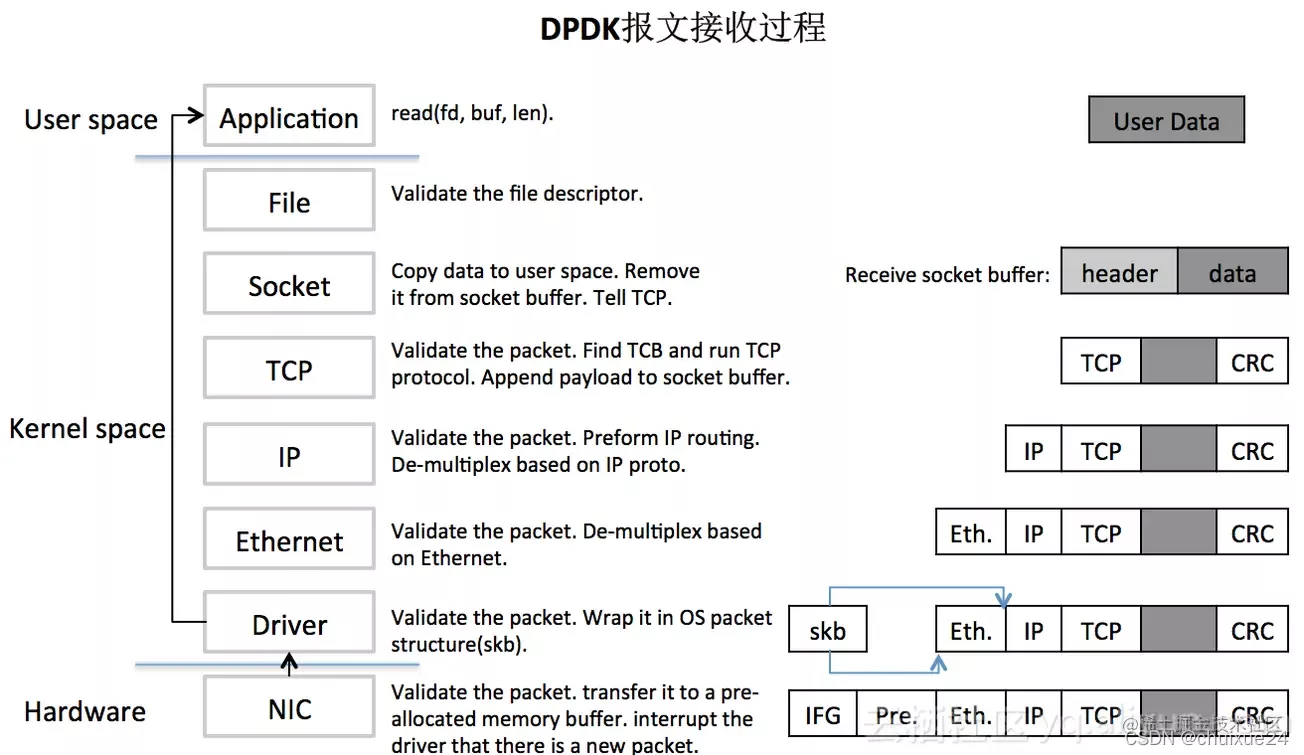

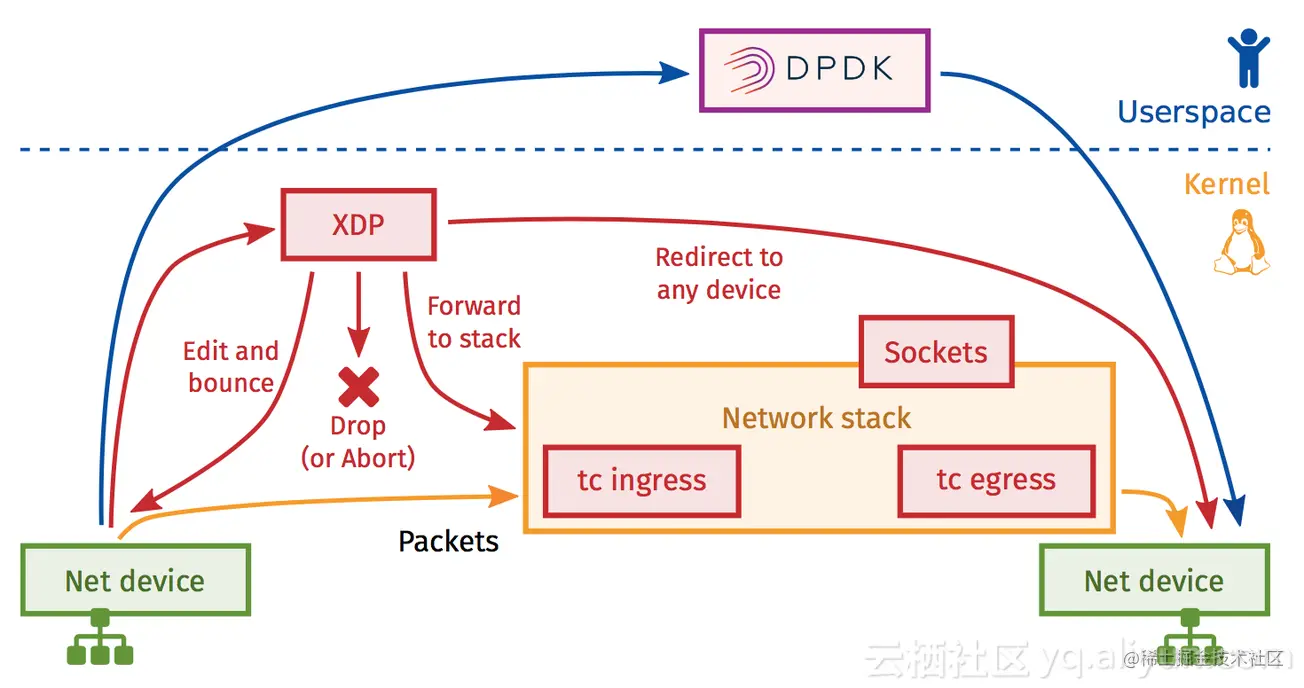

使用上述两个图表,我们可以看到运送和接收货物的整个过程。正如你所见,整个加工链仍然更长。还需要在核状态和用户状态之间复制记忆、上下文转换、硬件和软件中断以及硬件和软件中断。虽然Linux最初的意图是无所不在,但他未能实现这一目标。然而,鉴于Linux在服务器部门广泛使用,其最初的基于网络的数据集处理技术已经满足了对高性能网络数据处理能力的要求。DPDK 出现在这种环境中。其利用UIO技术,数据包立即装入司机楼层的用户状态程序。我一直在探索Linux军营以下步骤是用户程序完成所有后续任务。驱动程序用于发送数据 。原始核状态与用户状态之间的内存副本通过 mmap 将用户的内存映射到内核。这样可以消除内存复制、 Cforthtext 切换、 系统调用等等 。然后,机器的性能受到挤压,因为机器使用大量的记忆页、CPU的亲近、无锁的排队、旋转式驾驶模型和多核发射。因此,数据包处理效率提高了。说了这么多,在此之后,我们将审查获得和接收DPDK数据集的过程。如下图:

通过对比得知,DPDK拦截中断,这不是造成第二次混乱的问题。并绕过内核协议栈,UIO(用户空间一/O)技术向应用程序一级发送一份网页卡报告副本。报告不再由内核处理。减少了中断,用户空间内的内存库用于处理 DPDK 的所有软件包。内核空间与用户空间内存相互作用,而不复制。只做控制权转移,减少报文拷贝过程,信息传输效率有所提高。

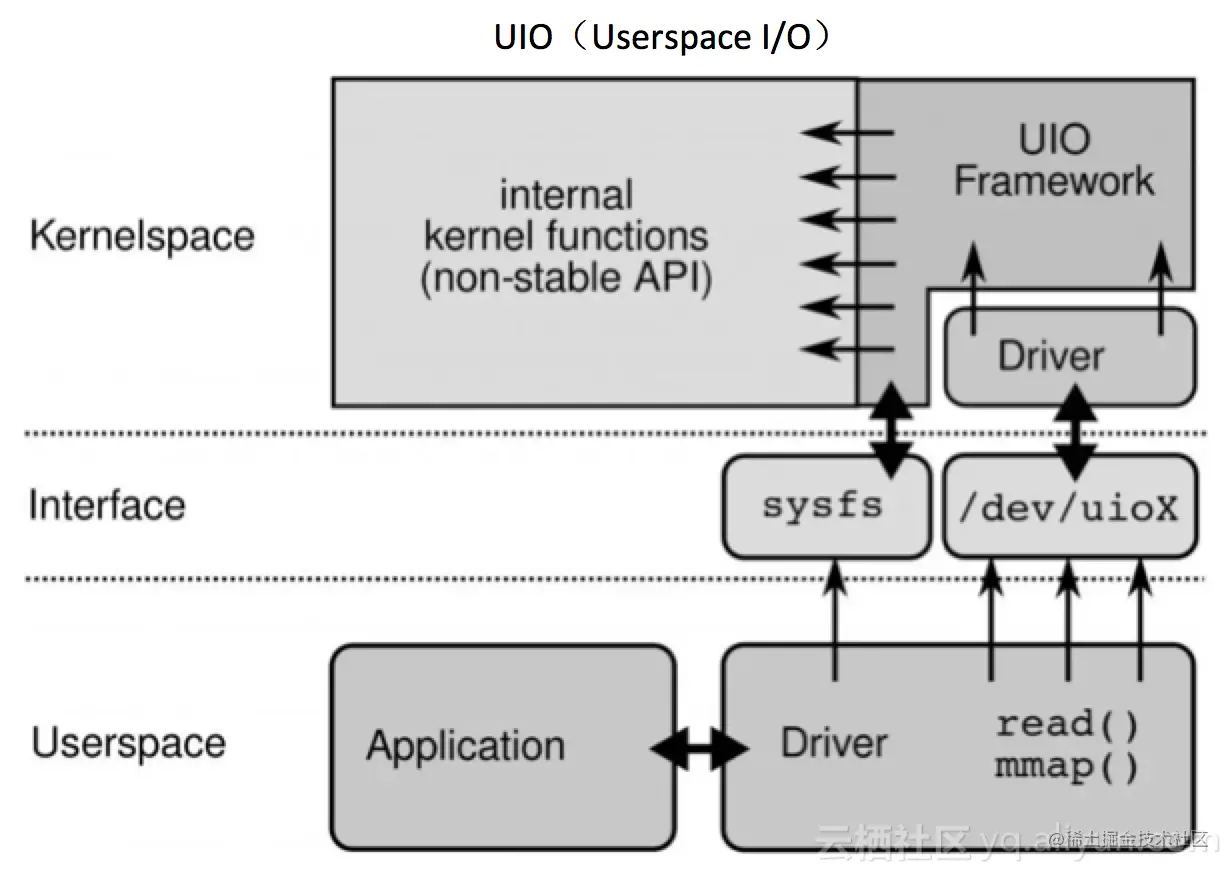

不像DDPK能绕过内核基本上是因为UIO技术DPDK没有发明UIO技术。这是一个在用户环境中运作的内核。 I/O 技术, Linux 该系统的主要驱动器现已投入使用。 内核 空间,在用户区域中,您可以援引应用程序。UIO则是将 驱动 其中许多国家在内核空间很活跃。绝大多数职能是在用户领域履行的。与UIO, 我们可以拦截干扰。这是政府第一次能够对自身采取行动。结果,内核过程被绕过了。

UIO是如何避免中断的?让我们来看看一个小玩意的两个主要角色:

UIO的实现机制的目的是让用户的空间暴露在文件界面上。例如,当注册UIO设备 uioX 时,最后,将有一个名为/dev/uioX的文件。文件的读写与设备内存的读写相对应。除此之外,以/sys/类/uio读写文件也可以用于控制设备。以下是UIO结构和流程图:不再赘述。

说完了DPDK,那么,是如何提高传输效率的呢?既然

Cilium

它以eBPF和XDP标准为基础。归根结底,XDP是使用eBPF的Linux内核高性能、可配置的网络数据路径框架。因为eBPF是这个系统的核心接下来我们来查查EBPF是什么

eBPF和XDP概要

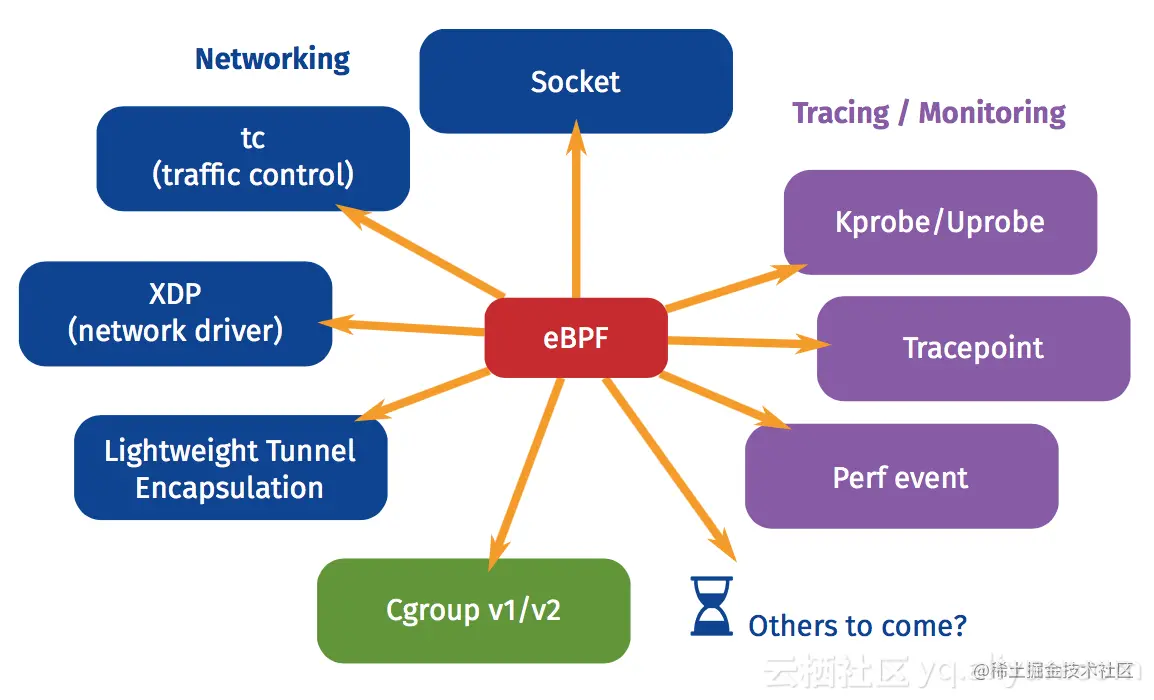

BPF启发了eBPF(扩展的伯克利包装过滤器)。它提供了内核包件过滤技术。开始在Linux执行eBPF。它扩大了BPF的功能。丰富了指令集。在内核里,它提供一台虚拟机器。用户国以虚拟机器指令的形式向内核传送过滤规则。根据这些指示,内核过滤器负责网络数据包。换句话说,我们可以指示内核按照我们的规格处理包件。这篇文章是全球之声在线特稿的一部分。你曾经相信eBPF总是很棒吗?既然都这么强大了,是否有最佳做法或应用清单?请看下图:

我们可以看到,XDP本身是一种电子BPF最佳做法,其余部分已不再开放,因为它与本文件所述内容无关。

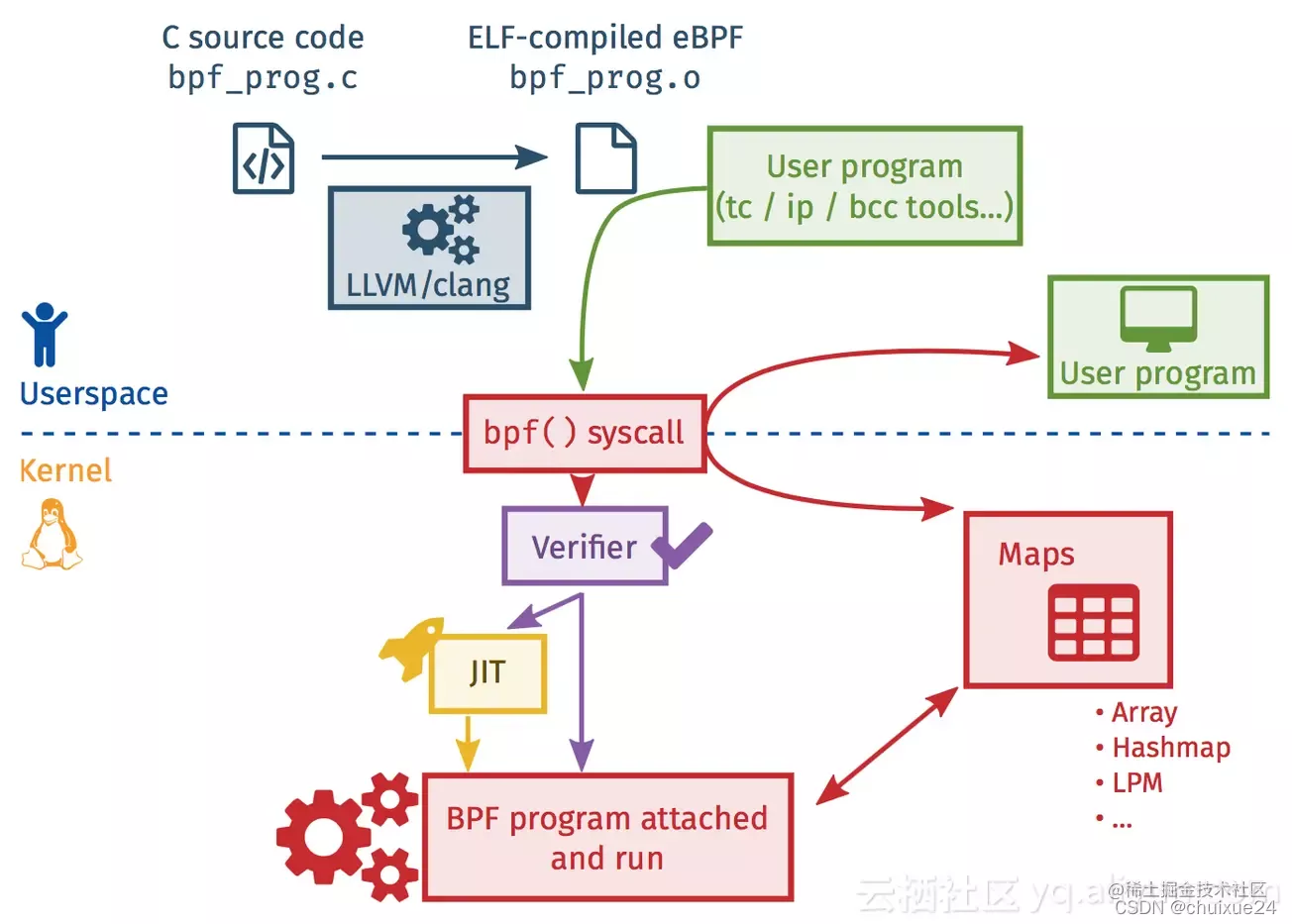

首先是用户。 当 c 文件建立时, 自动生成 eBPF 字节文件会创建 。这是一组命令然后通过系统呼叫将字节代码注入内核。内核然后核查合法性。JIT公司在核查后被雇用运行。在数据交换方面,使用eBPF程序运行的用户程序使用内核给出的标准地图。

与DPDK不同,DPDK在用户空间执行所有记忆,以防止记忆复制、上下文转换、系统呼叫等等,eBPF在核空间执行所有记忆。 然而,两者的核心在于通过消除核国家和用户国家之间重复数据包的传输效率。

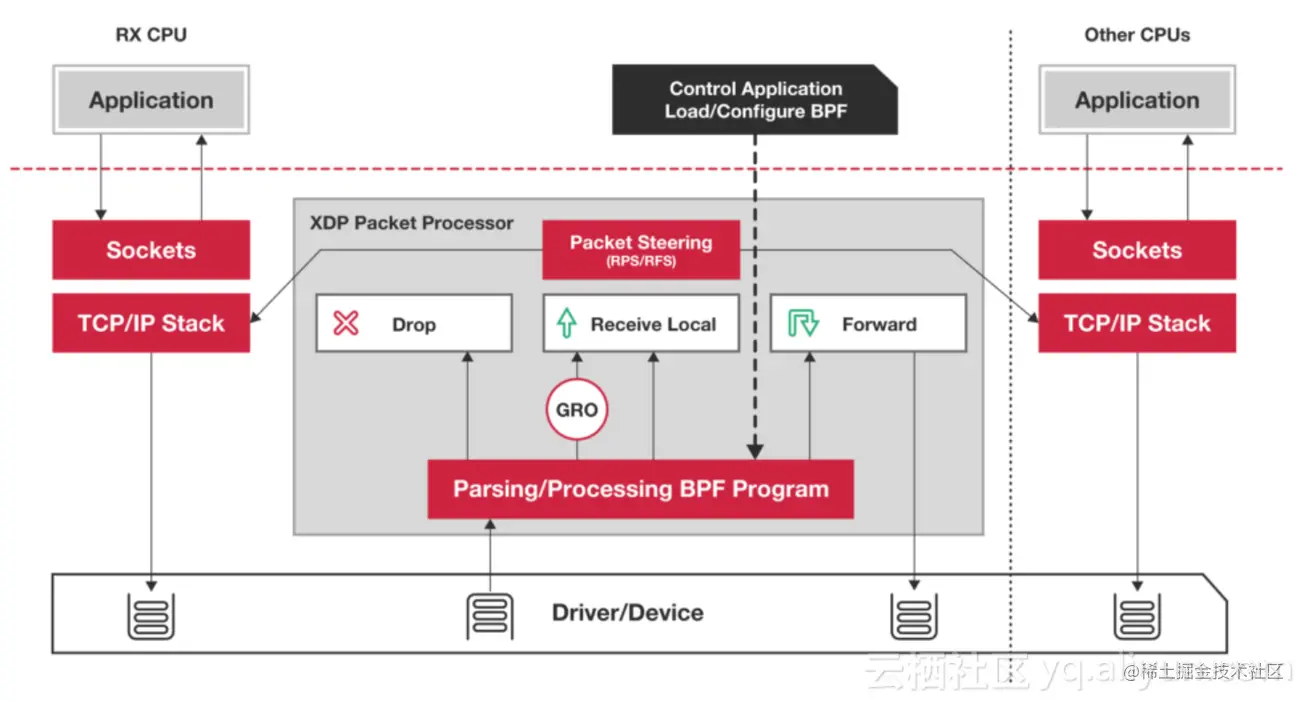

说完了eBPF,然后XDP墨到来就Linux内核而言,XDP(xxpress数据路径)提供了一个高性能、可配置的网络数据通道。网站受到当局的限制,因为网络软件包是在进入网络协议储存之前处理的。它使Linux公司的业绩大有改善(大大超过DPDK公司)。

Linux 内核4.XDP中的XDP是一个内核函数,与DPDK不同的内核合作运行,DPDK在进入协议柜台之前截获数据包并将其分配给 k_buff。

此外,XDP还汇编用户应用程序并创建eBPF字节文件。将内核执行包过滤器输入内核在数据包进入内核仓库之前,先进行XDP软件包过滤。如果确定包件不需要额外处理,可直接送往国内核国家,如果TX设备不及时处理,货物将丢弃。如果确定包件必须再处理,将移至协议仓库。

XDP 如何得出比 DPDK 效率更高的结论? 使用下面的图表,你也许可以确定自己的答案。

作为数据报告的新资产,XDP的绩效效益是不言而喻的,但它是否完美?答案必须是否定的,并且有两个缺陷:

关于eBPF和XDP已经谈了很多。它是否更新了行业最佳做法?是的,现今的Katran项目在脸书上公开提供,使用这两种技术。据称,在从IPVS转向eBPF之后,政府不再能够这样做。其业绩增长了十倍。由Linux社区成员在XDP实施的基本出入防火墙可以很容易地每秒处理1 100万个数据包。

简说QUIC协议

在讨论如何有效地转达请求之后,让我们讨论如何在Sidecar之间有效沟通。

在讨论来文时,有必要讨论来文协定。这里不讨论TCP和UDP这两个我们大家都熟悉的基本通讯议定书的利弊。因此,能否将TCP和UDP的好处结合起来?这保证了TCP的可靠性和安全性。除了民主联盟的速度和效率之外,政府一直在处理各种专题。显然,这经常是由于人们渴望最佳的结果。是剧本将我们推向前进。QUIC是建立在这种承诺基础上的。目标是建立一个几乎相当于TCP的单独联系。但有着低延迟,也增加了对多常规再流入协议的支持,如SPDY。

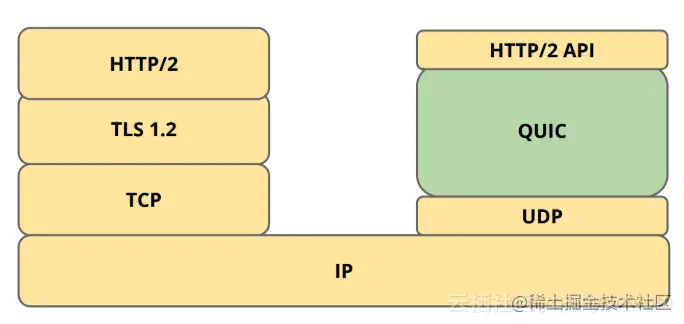

QUIC协议没有使用目前的 TLS 1. 2,而是建造了自己的 TLS 仓库,以完成自己的传输加密层。 同时,QUIC 也有HTTP/2实现的部分内容,因此QUIC 的状况如下:

QUIC协议的创建是为了减少网络延误,创新地使用UDP协议作为底层转移协议,以各种方式减少了网络延误,从而取得了相当大的速度增益,特别是谷歌旗下的YouTube上确认的修改。

由于QUIC协议比其他现有协议更为有利,因此比QUIC协议更为重要。它是否也适用于特使?特使团体提倡对其结构进行正式重新设计,其目标之一是QUIC, QUIC是其职能的一个关键组成部分。最终目标是将QUIC用作Sidecar之间的通信协定。

考虑一下,如果特使使用这一技术,可能会发生什么情况,这应该留给官员处理。

我不确定你是否在这里会有任何这样的调查。在ServiceMesh,许多侧面车现在作为数据板发挥作用。为什么特使对表现如此直言不讳?这使我们回到一个老主题。因为特使是用C编程语言创建的操作系统特性的应用具有自然效益。

杂谈

如前一部分所述,有些技术与特使相似,例如Linkerd、Conduty和NginMesh,下文仅简要讨论这些技术的个人知识,仅供参考。

就个人而言,事实上,我希望管道的成熟。按其原意量化。与Istio的广泛部署模式相反这对小型企业来说是理想的,它们需要迅速起步运行。管道和Linkerd都住在同一栋房子里它足以保证其设计哲学是尖端的。虽然Buoyant声称管道公司和Linderd公司的目标对立,但无法解决这一难题。但我不相信Buyant有什么问题计划启动全套服务网目计划, 以破坏伊斯蒂奥家族独特的困境。近年来,我们得以重新获得创建者在服务网的特权。

以下是他们各自特点的简要说明。

NginMesh:

NginMesh更等同于建造一座伊斯蒂奥桥。我只负责将Istio的配置信息转换成Nginx所理解的内容。重新启动 Nginx 以应用设置 。这只给我一种短期计划的感觉 进入"服务 Mesh"。

Linkerd:

作为"服务网"思想的创造者和传道者最后,在服务网潮中,他遭到谷歌、IBM和Lft-lead财团的Istio + 特使、Google、IBM和Lft-lead财团的殴打。很难想象巨人的力量 和启动人的脆弱和挣扎这是我第一次看到这样的事逆杀Istio。这是弱者的心态吗?哈哈。

Conduit:

本文由 在线网速测试 整理编辑,转载请注明出处。