再聊数据中心网络

最后更新:2022-06-10 09:17:52 手机定位技术交流文章

就在前一天,小朱发表了一篇关于数据中心网络的文章,许多读者留下一个信息说他们不明白。

基于科学与技术的最终沟通的原则,我今天将继续讨论这个话题。

故事必须从一开始就讲出来。

1973年夏天,两位年轻科学家(温顿·托尔夫和罗伯特·卡恩)开始研究一种新生的计算机网络,以寻找不同机器之间的通信方式。

不久后,他们用黄色手签绘制了一个TCP/IP协议家族的原型。

几乎同时,施罗德公司的梅特卡夫和博格斯发明了Ethernet。

正如我们所知道的,互联网最早的原型是ARPANET,它是由美国老人开发的。

ARPANET最早的协议过于粗糙以满足计算节点大小增加的需要。 1970年代末,洋基以TCP/IP(1978)取代了ARPANET核心协议。

1980年代末,随着TCP/IP技术的出现,ARPANET迅速发展,产生了许多兄弟姐妹,这些兄弟姐妹互相连接,互相连接,成为世界著名的互联网。

可以说,TCP/IP技术和Ethernet技术是互联网早期兴起的基石,它们低成本、结构简单、易于开发和部署,对计算机网络的扩散做出了巨大贡献。

然而,随着网络的迅速扩张,传统的TCP/IP和Ethernet技术开始表现出弱点,无法满足宽带和高速发展互联网的需求。

第一个问题是储存.

早期存储器(英语:Early storage)是一台机器安装的硬盘,通过IDE、SCSI、SAS和其他接口将硬盘连接到主板,并通过主板的总线实现CPU、内存和磁盘数据存储。

后来,存储容量的需求增加,考虑到安全备份(需要RAID1/RAID5),硬盘数量增加,一些硬盘变得不安全,服务器无法容纳它们。

磁阵,磁盘阵列

磁盘阵列是一种专门放置磁盘的装置,它大约有几十个。

硬盘数据存储一直是服务器的瓶颈。 最初,用于连接服务器和阵列的网络或特殊的电缆被发现是不够的,所以我们开始使用光纤。

在200年左右,光纤通道仍然是一个相对高技术、低成本的技术。

当时,公共通信网络的光纤技术处于SDH155M和622M阶段,2.5G的SDH和波共享技术刚刚开始,没有普及。后来,光纤才开始爆发,容量开始迅速跃升,10G(2003年),40G(2010年),100G(2010年),400G(現在)。

光纤不能在数据中心的普通网络中使用,所以你可以继续使用网络线和Ethernet。

当时,服务器之间的通信需求并不那么高。 100M和100M的线程几乎无法满足一般业务的需求。

2010年,重新发行。

除了存储外,由于云计算、图形处理、人工智能、超级计算机和Bitcoin的混乱,人们开始关注计算。

摩尔定律逐渐衰弱,不再能够支持提高CPU计算能力的需要。 随着牙膏的挤压变得更加困难,GPU开始上升。

由于人工智能的迅速发展,各种公司开发了人工智能芯片、APU、xPU等。

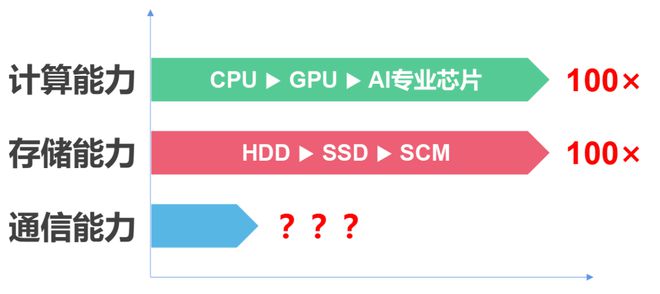

计算能力的指数增长(超过100倍)的直接后果是服务器数据吞吐量的指数增长。

除了AI对变量算术的需求外,数据中心的趋势也发生了重大变化,即服务器与服务器之间的数据流大幅增加。

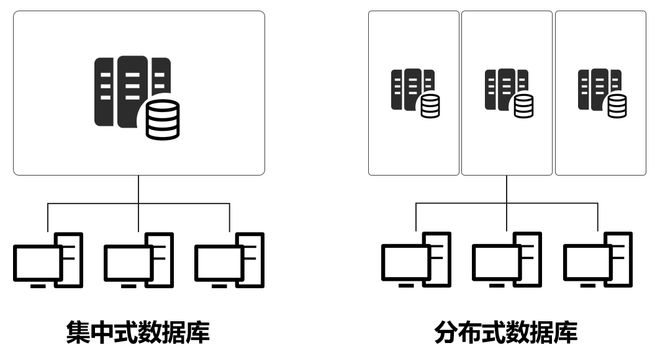

随着互联网的迅速发展和用户数量的迅速增加,传统的集中计算架构无法满足需求,开始转变为分布式架构。

例如,现在是618,每个人都在血中。 一百八十个用户,一个服务器,一个百万,一个亿,当然不是。

在分布式架构下,服务器之间的数据流量大大增加,数据中心内部的互联网网络的流量压力稳步增加,数据中心和数据中心之间也是如此。

这些水平数据报告(专业术语指面向某物的)有时甚至特别大的,一些图形处理的数据,包装大小甚至Gb水平。

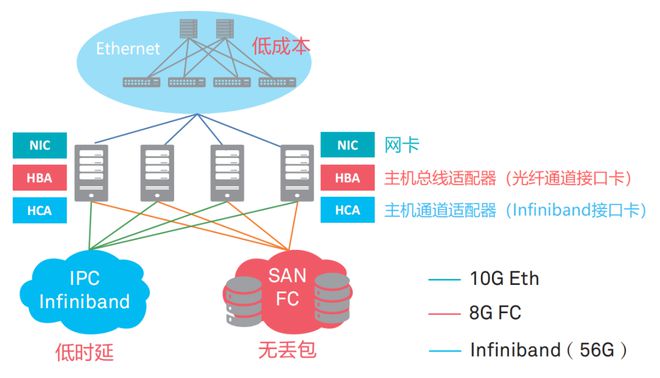

综上原因,传统的以太网对于这种大规模数据传输的带宽和时间延迟(高性能计算,拖延的需求非常高。所以,一些制造商已经开发了专门的网络通道技术专有协议,即,InfiniBand网络(译为“infiniBand”技术,缩写为IB)。

FC vs IB vs Ethernet

IB技术延迟非常低,但生产成本高,维护复杂,与现有技术不兼容,因此,与FC技术一样,只能在特殊需求下使用。

同时,硬盘不是孤单的,而是SSD的固体硬盘,取代了机械的硬盘。 记忆,从 DDR到 DDR2, DDR3, DDR4,甚至 DDR5,也是一个精力充沛的淫亵发展,增加频率,增加带宽。

处理器 、 硬盘 和 内存 的 能力 爆炸, 最终 将 压力 转移 到 网络 卡 和 网络 。

已研究计算机网络的学生知道传统的Ethernet是基于“载体听多路径访问/冲突检测(CSMA/CD)”的机制,这种机制非常容易产生拥塞,导致动态时间的大幅延迟,并且经常出现数据包的丢失。

在TCP/IP协议方面,它们运行的时间太长,40岁,并且有许多错误。

例如,当一个TCP协议堆接收/发送消息时,内核需要多个上下文到文本的更改,每个需要大约5到10 us的延迟。 此外,至少需要3份数据副本,协议加密取决于 CPU。

尽管这些协议看起来很小,只有十个微秒,但对于高性能计算来说是难以承受的。

除了时间延迟问题外,TCP/IP网络需要多个主机CPU参与协议堆栈内存复制。 网络越大,带宽越高,CPU在接收和传输数据时的调用负载越高,导致CPU的连续高负载。

根据行业测定的数据:每份1位数据传输需要1Hz的CPU,因此当网络带宽达到25G以上(全负载)时,CPU需要25GHz的计算能力来处理网络。

那么, switch to a network technology是简单的吗?

不,不,太难了。

CPU 、 硬盘和内存都是服务器内部的硬件, 开关和关闭, 与外部无关.

但通信网络技术,即外部互联技术,是通过协商交换的。 我改变了,你没有改变,网络爆炸了。

你认为把全世界的转换技术同时统一是不可能的吗?

所以,就像现在一样,IPv6取代了IPv4,它是渐进的,首先是双重堆栈(同时支持v4和v6),然后慢慢地消除v4。

数据中心网络的物理通道,光纤置换网络线路,也是较容易的,首先是小规模的改变,然后逐渐扩大。

网络卡容量不足的问题也较好解决了,因为CPU不计数,网络卡本身也计数。 因此,现在有一个智能网络卡很热,这在一定程度上是计算的失败。

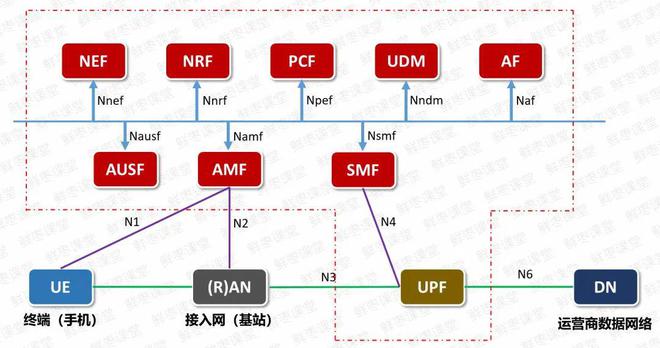

一个在5G核心网络上工作的同事应该非常熟悉5G核心网络媒体侧网络元素UPF,带有所有业务数据的无线侧,巨大的压力。

现在,UPF网络已经采用了智能网络卡技术,网络卡本身可以处理协议,降低CPU压力,流动吞吐量甚至更快。

如何解决数据中心通信网络架构的问题? 专家们花了半个小时的时间思考,或者很固执地决定改变架构,从服务器内部通信架构的角度重新设计了方案。

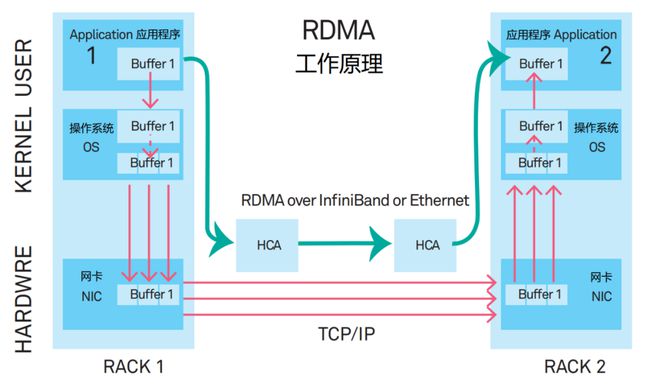

在新的系统中,应用数据不再通过CPU和复杂的操作系统直接与网络卡通信。

这是一个叫做远程直接存储访问(RDMA)的新通信机制。

RDMA等同于“破坏中介人”或“躲在门后面”的技术。

RDMA的内核绕过机制允许应用程序直接在网络卡之间读写数据,减少服务器数据传输的延迟到接近1us。

同时,RDMA的内存零复制机制允许接收机直接从接收机内存读取数据,大大降低CPU负担和提高CPU效率。

RDMA的性能比TCP/IP要强得多,并且它逐渐成为主流网络通信协议堆栈,并且将来肯定会取代TCP/IP。

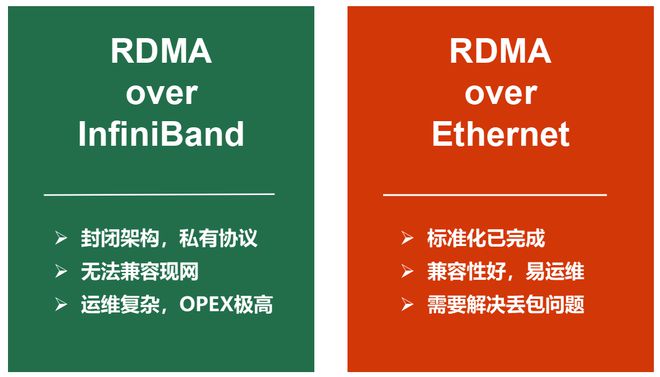

RDMA有两个类型的网络加载方案,即专用InfiniBand和传统的Ethernet。

RDMA最早在InfiniBand网络中引入。

然而,InfiniBand是一个封闭的架构,交换器是一个由特定制造商提供的专门产品,采用私有协议,与当前的网络不兼容,加上操作的要求过于复杂,对于用户来说不是一个合理的选择。

因此,专家们正在计划将RDMA转移到Ethernet的互联网上。

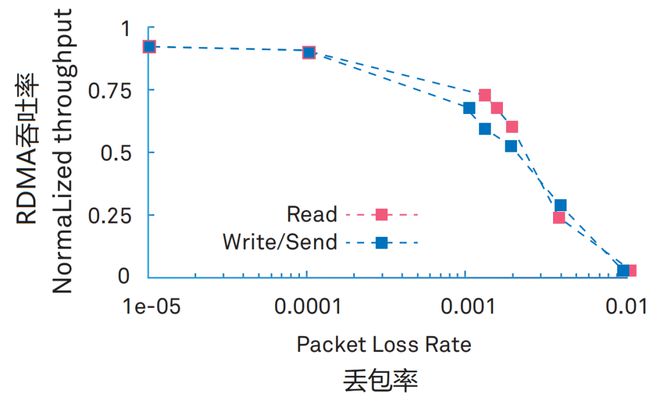

更令人尴尬的是, RDMA和传统的Ethernet结合在一起, 存在一个大问题.

RDMA需要很高的损失率。 1%的损失率会导致RDMA的吞吐率急剧下降。

尽管InfiniBand网络是昂贵的,但它可以实现无损失或损坏。 因此RDMA匹配InfiniBand,不需要设计一个完美的损失保护机制。

现在,与传统的互联网环境相比,互联网对生活的态度是两句话:"滑落"。 电子邮件包装,采用了"尽力为"的原则,丢弃包装是常见的食品,丢弃它并传递。

因此,专家必须解决以太网包丢失问题,以实现RDMA到以太网端口。

简言之,让Ethernet做零包装,然后支持RDMA。 RDMA可以实现超融合数据中心网络。

至于零包装技术细节,我不会太详细,但让我们看一下前一天的文章(再看一遍:)。

worth noting that the introduction of AI's network intelligent harmless technology is Huawei's first, but super fusion data center, is a public concept.In addition to Huawei, other manufacturers (such as Faithful, Lenovo, etc.) also talk about super-fusion data centers, and the concept is hot in 2017.

什么叫超融合?

精确地说,超级融合是一个包含各种业务类型的网络,例如HPC高性能计算、存储和一般业务。

超融合不仅满足了性能上的低时延和大宽带变量要求,而且具有低成本,不会过高昂贵,也不会过难维护。

未来,在整个网络架构中的数据中心,这是一条通往山脊网的黑暗之路.路由交换调度上,SDN 、 IPv6 和 SRv6 正在缓慢发展。微观架构上,RDMA技术发展,替换TCP/IP。物理层上,全光继续发展,400G、800G、1.2T…

我的个人猜想是,电解质和光解质层的当前混合物最终将成为光的整体。 光通道穿过光,它进入服务器,服务器主板不再是普通的PCB,而是光纤后板。

光通道是王道

在路由调用中,它将是人工智能的世界,网络流量,协议,所有都由人工智能控制,没有人需要干预。

好吧,这就是我要告诉你的关于数据中心通信网络的全部内容。

如果你不明白,你就会再看一遍。

—— The End ——

本文由 在线网速测试 整理编辑,转载请注明出处。